ChatGPTのブラウジング機能とBardとBingのAIチャット機能でリサーチした時、直近の情報をどれくらい反映してくれるのかを知りたかったので、「THE SECOND」の開催翌日に大会の結果について、それぞれに同じ質問をしてみました。

ChatGPTにブラウジング機能が実装されてから、Bardとの比較を日々やっているんですけど、ChatGPTが間違うこともありますし、Bardが正解することもありますし、もちろんその逆もあるんで、あくまでお遊び的な実験だと思っておいてください。

目次

質問①THE SECONDで優勝したのは?

それでは、ChatGPTとBardとBingのAIチャットに同じ質問をして、それぞれの回答を見比べてみます。

最初の質問は「THE SECONDで優勝したのは?」と、シンプルな質問から試してみます。

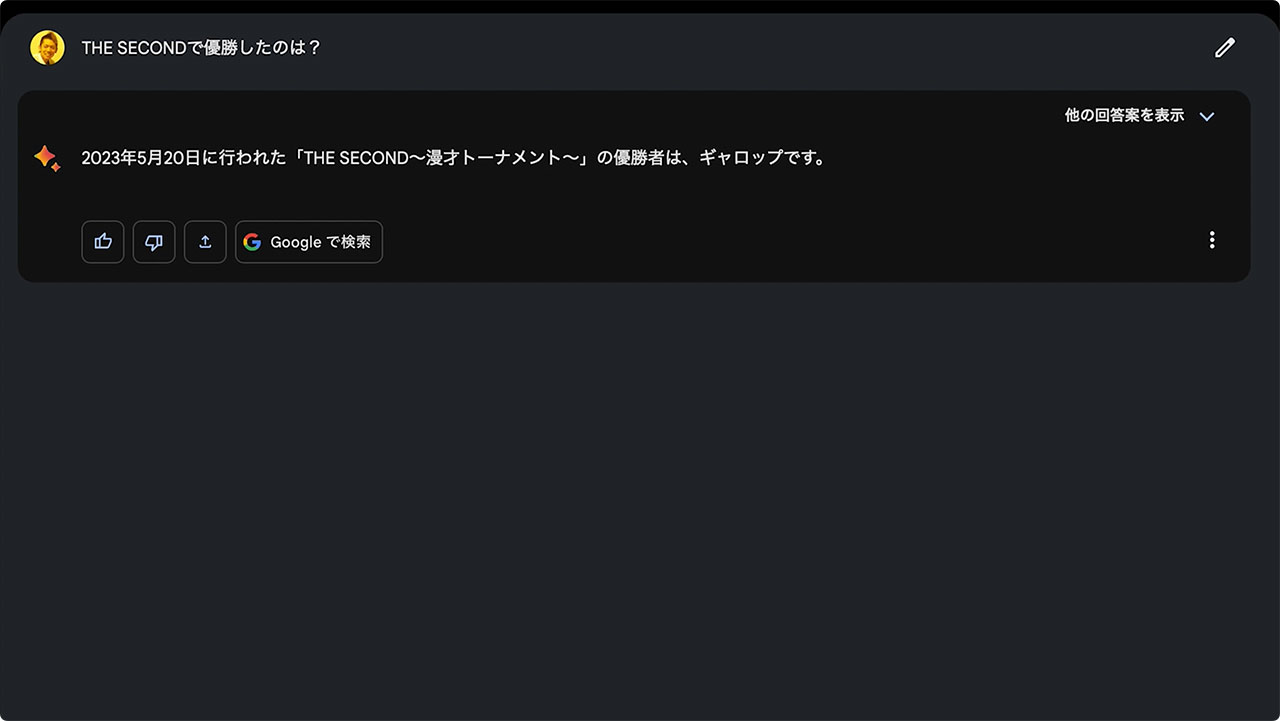

ChatGPT Browsing機能の回答

ChatGPTの回答は「THE SECONDの優勝者はギャロップでした」という具合に正確な回答をしてくれました。

ChatGPTのブラウジング機能をオンにすると、回答が表示されるまでに時間がかかることが多いんですが、今回は短いシンプルな質問だったからか、あっという間に回答が表示されました。

Bardの回答

次に同じく、「THE SECONDで優勝したのは?」という質問をBardに投げてみます。Bardはとにかく回答が速いのが特徴です。優勝者がギャロップであることに加えて、「THE SECONDのサブタイトルまで正確に出力してくれています。

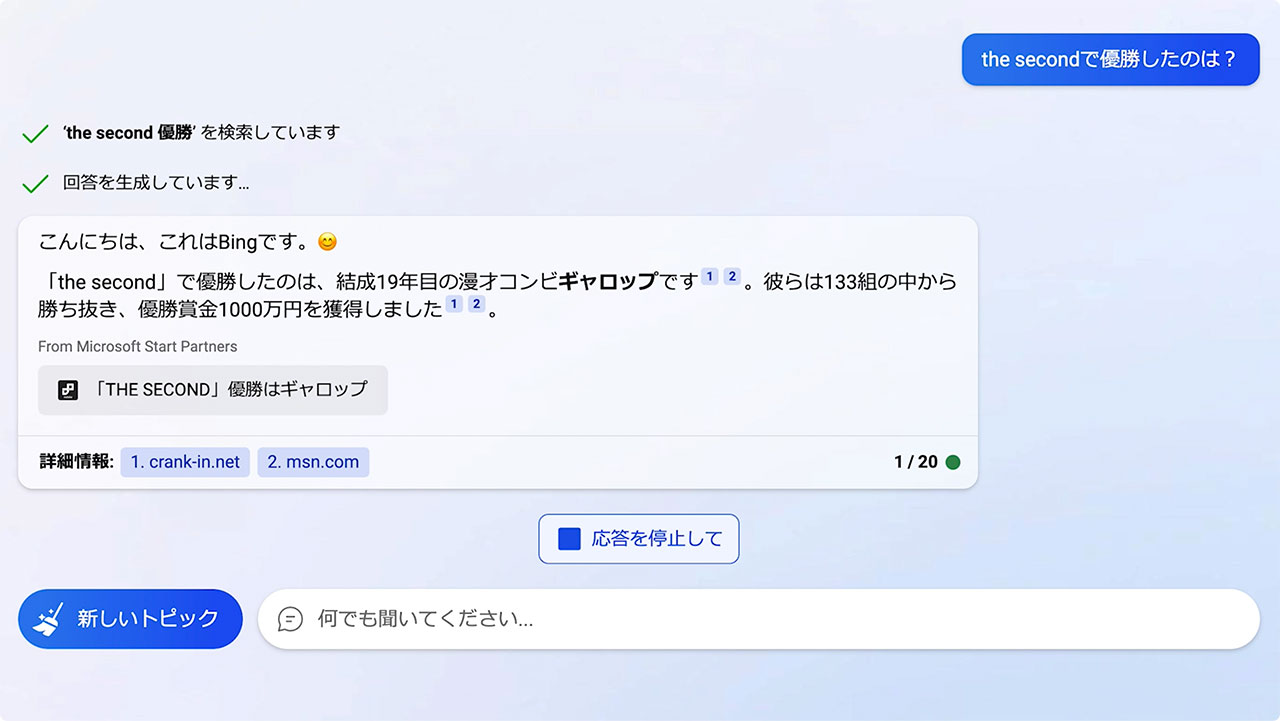

Bing Aiチャット機能の回答

最後に、BingのAIチャット機能にて「THE SECONDで優勝したのは?」という同じ質問をしてみます。Bingもチャットと同じくGPT-4を搭載していて、出力にやや時間がかかるものの、正確な回答をしてくれるのが特徴です。こちらもギャロップが優勝したことを正確に回答してくれました。

ちなみに、BingのAIチャットの場合、関連する記事と次の質問の候補も表示してくれるのが便利です。

質問①THE SECONDの最高得点は?

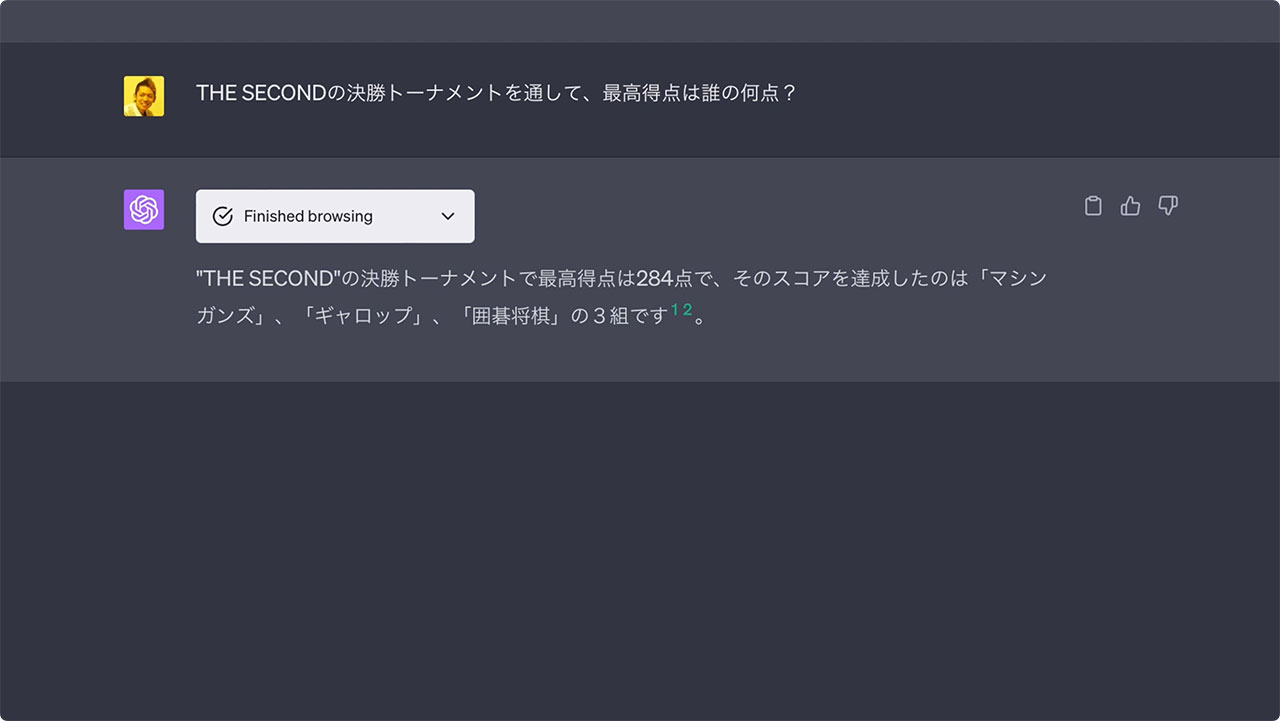

次の質問ではもう少し踏み込んでみます。「THE SECONDの決勝トーナメントを通して、最高得点は誰の何点?」という質問をしてみました。

こちらはちょっとしたひっかけ問題というか、今回の大会で最高得点は284点で、3組が並んだんですね。

最高得点という言い回しから、1組だけをピックアップする可能性がありそうだなと思い、この質問にしてみました。

ChatGPT Browsing機能の回答

ChatGPTは正確に、マシンガンズ・ギャロップ・囲碁将棋の3組が最高得点である284点を獲得したと回答してくれました。

Bardの回答

続いて、Bardに「THE SECONDの決勝トーナメントを通して、最高得点は誰の何点?」という同じ質問をしてみたところ、見事引っ掛け問題に引っかかり、マシンガンズとだけ回答しました。

Bardは3つの回答から選択できるのも特徴で、他の回答も見てみましたが、他の回答はさらに間違った情報が山盛りでした。こんなことを言いたくはないんですが、マシンガンズは数々の賞を受賞してません。これまで受賞経験がないから感動があったんです。

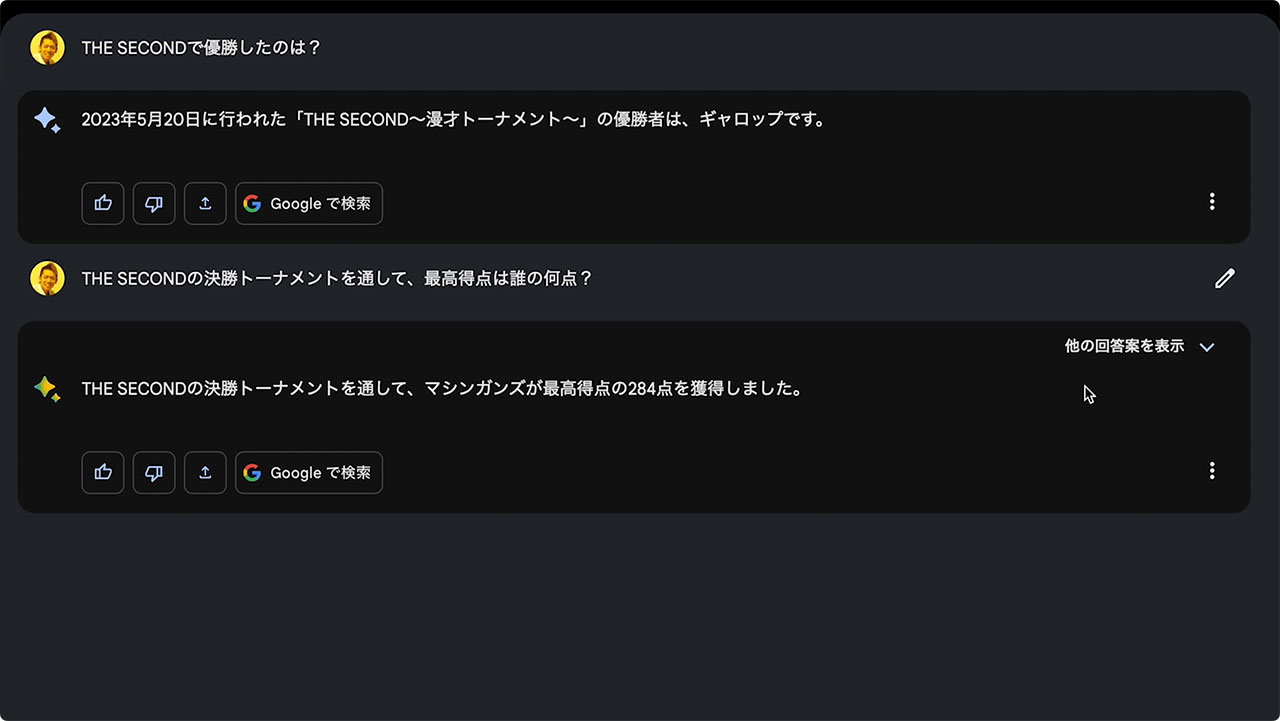

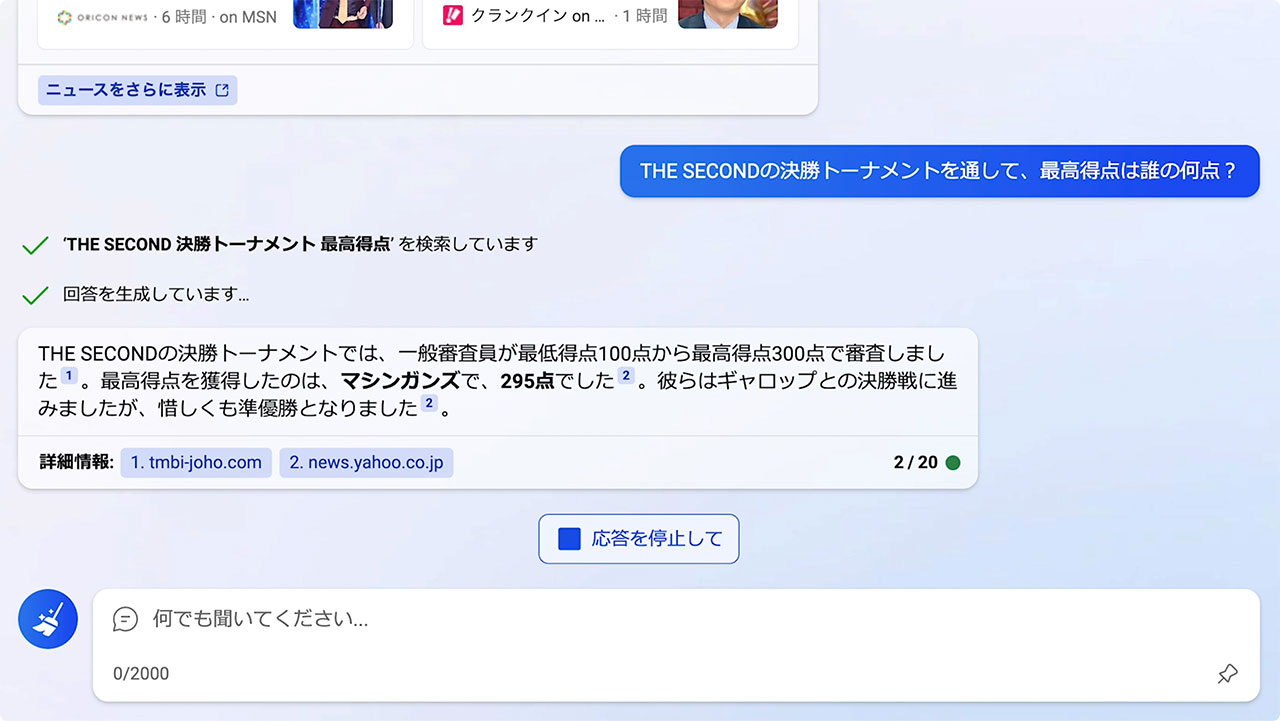

Bing Aiチャット機能の回答

BingのAIチャットでも同じく「THE SECONDの決勝トーナメントを通して、最高得点は誰の何点?」という質問を投げたところ、得点自体も間違っていました。

BingのAIチャットに限らず、対話型AIサービスはこういうことがたびたび起こるので、情報を信頼しすぎないようにしましょう。

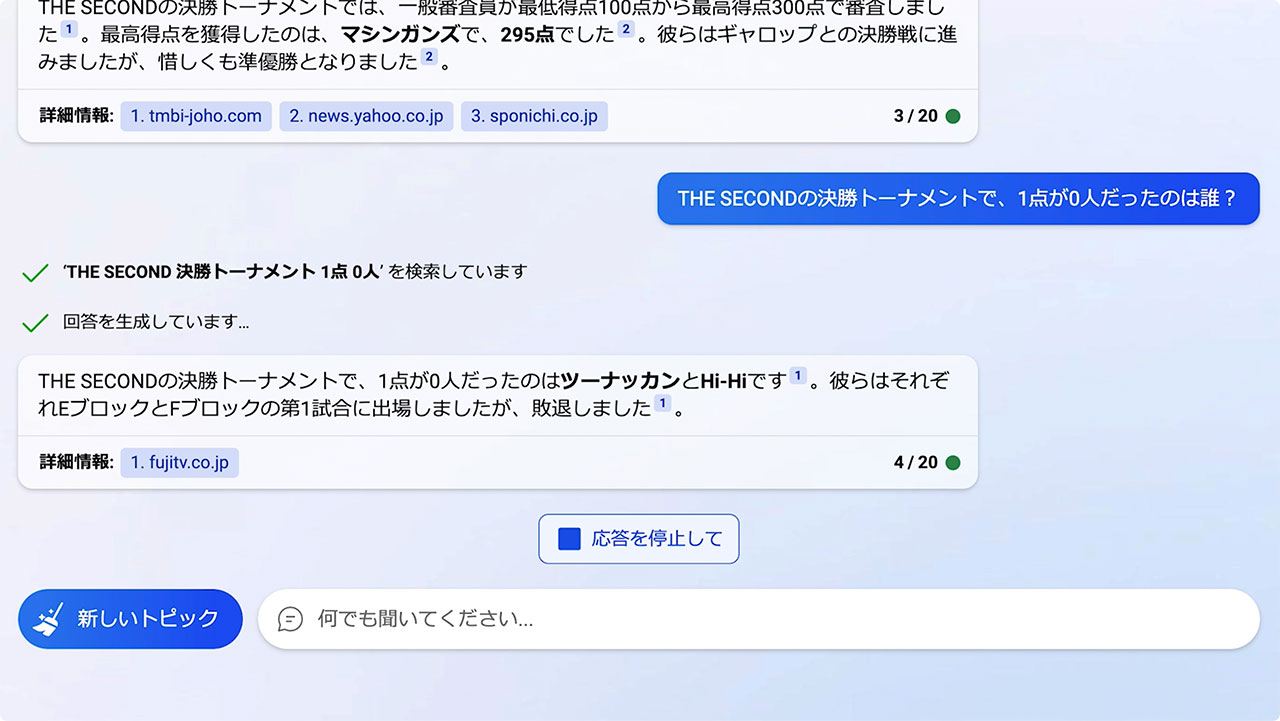

質問③1点が0人だったのは?

最後にもうちょっと複雑な質問をしてみます。THE SECONDは審査員100名がとても面白かったら3点、面白かったら2点、面白くなかったら1点を入れるシステムで、決勝トーナメントを通して、1点が1人も入らなかったのはギャロップと囲碁将棋の2組だけでした。

これをふまえて、「THE SECONDの決勝トーナメントで1点が0人だったのは誰?」という質問をしてみました。

ChatGPT Browsing機能の回答

この質問に対して、ChatGPTでは正確に回答してくれました。

ChatGPTのブラウジング機能、ここまでの3つの質問はパーフェクトですね。だいぶ信頼度高いです。

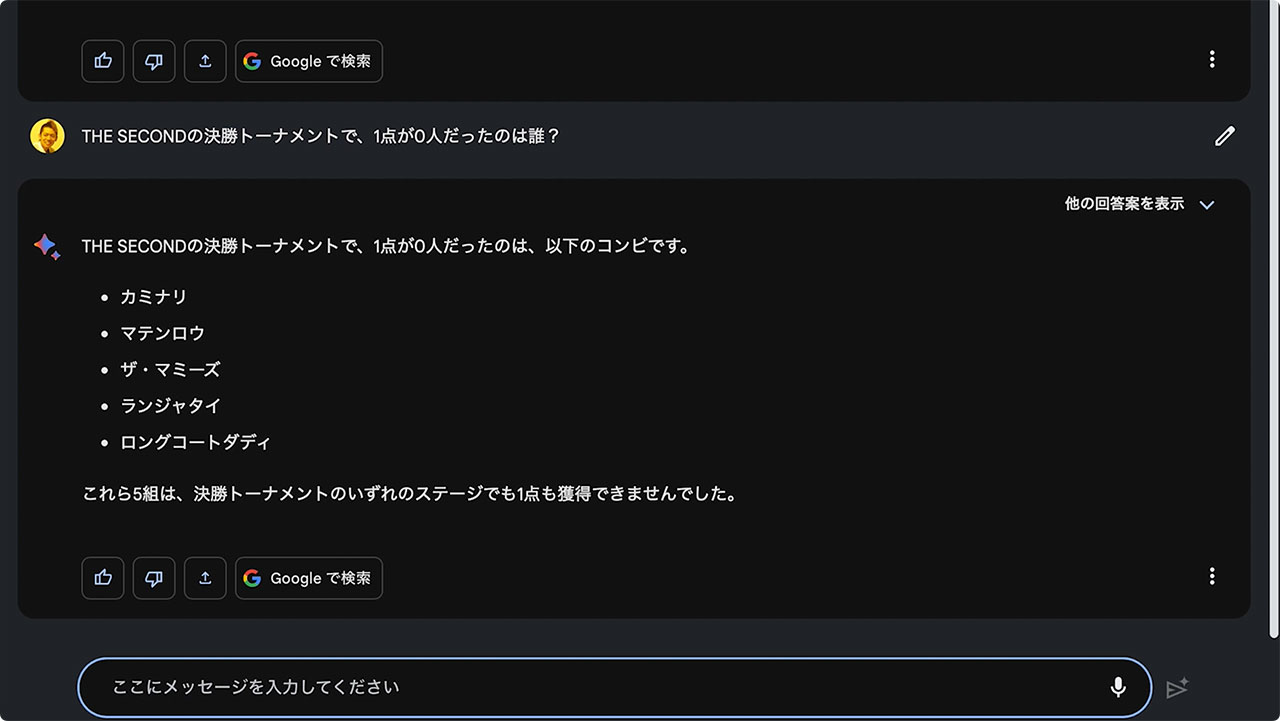

Bardの回答

Bardで同じく、「THE SECONDの決勝トーナメントで1点が0人だったのは誰?」と質問してみたところ、ついにBardのポンコツっぷりが出てしまいました。出場していない芸人さんの名前を羅列しています。

他の2つの回答を見てみても間違いだらけで、そんな中に正解であるギャロップの名前も含まれていたり、若干の真実が混ざっているのが余計に厄介です。

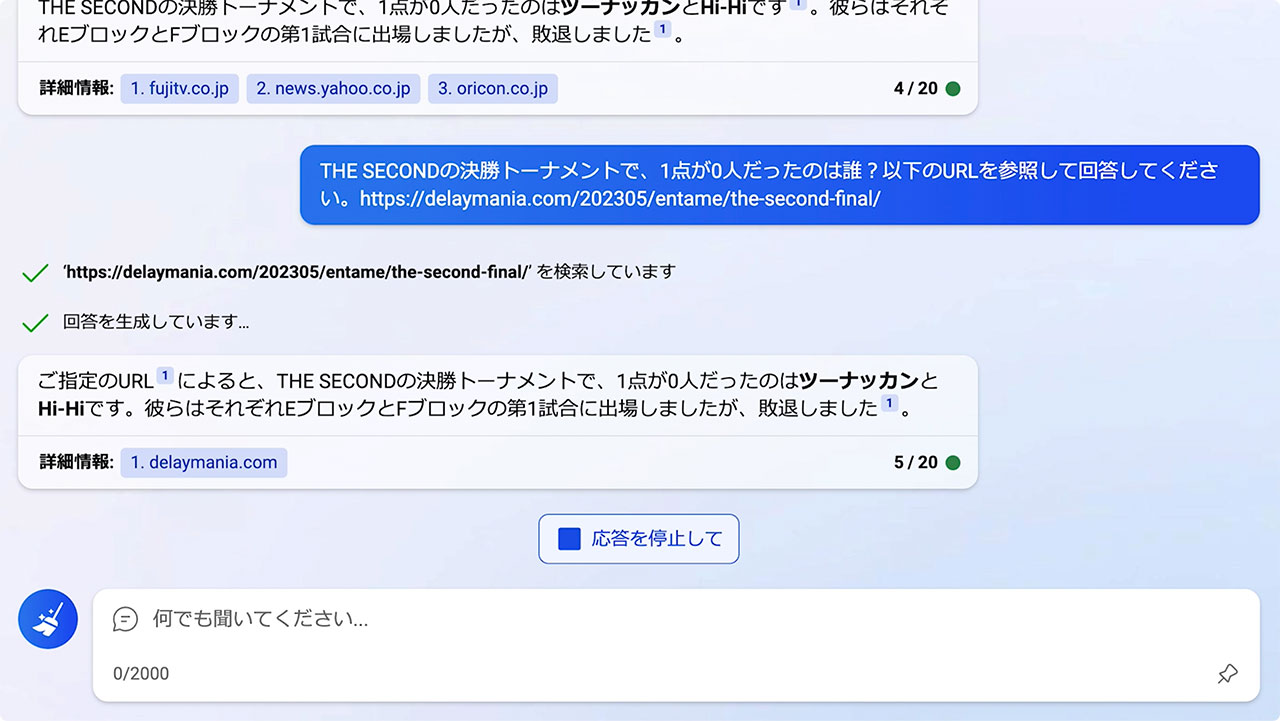

Bing Aiチャット機能の回答

この質問に関しては、BingのAIチャットも正確な回答ができませんでした。

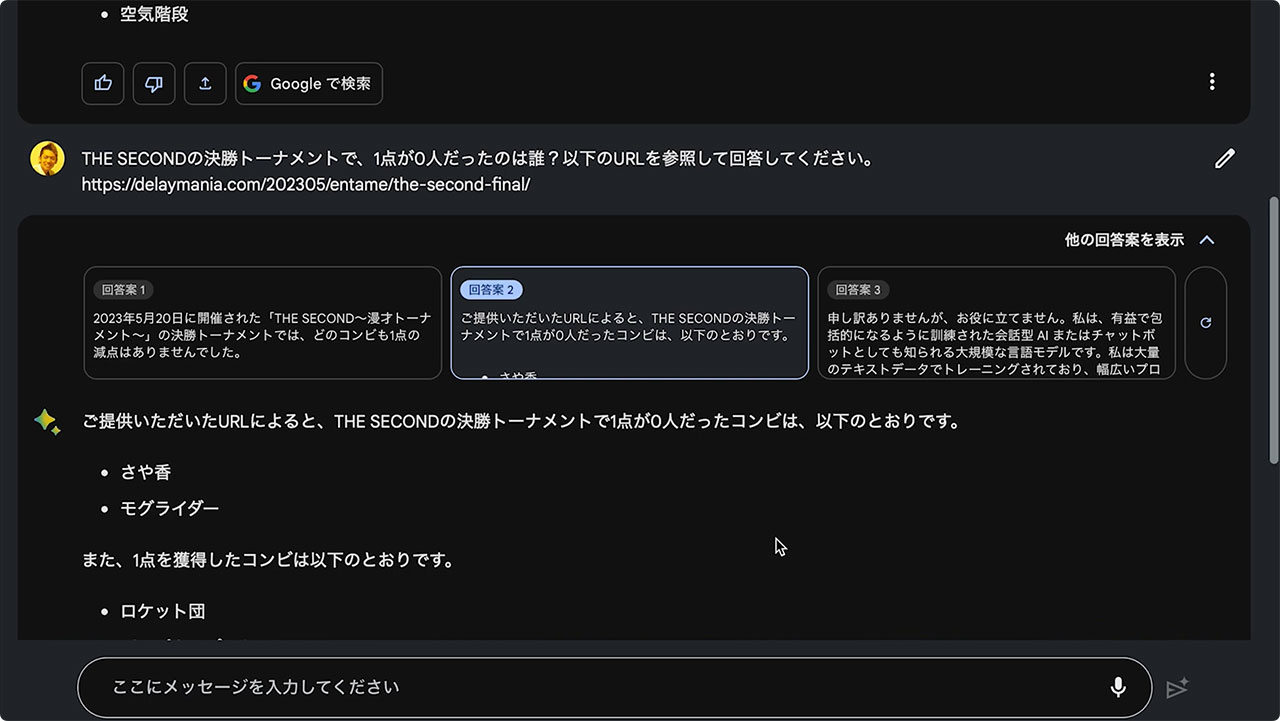

参照元URLを貼り付けて質問した場合

正解の情報が記されたページのURLを貼り付けることで、正確な回答を導き出せることがあるため、Bardで試してみましたがこれもダメでした。

大会のルールをきちんと説明した上で質問しないと、正確な回答までたどり着けないかもしれません。

BingのAIチャットでもURLを貼り付けて質問してみましたが、こちらでは先程と回答が全く変わらなかったので、BingではURLを貼り付けても該当するページを参照してくれていないかもしれません。

最後に

今回の結果だけを見ると、やっぱりChatGPTが最強だなって思ってしまうんですが、ChatGPTはブラウジング機能を使うと回答に時間がかかるデメリットもありますし、質問によっては間違った回答することもありますので、最終的には合ってるのか間違ってるのかを自分で調べ直して検証して使うのがいいと思います。

また、Bardはベータ版ということもあって、今後どんどん進化していくと思いますので、そちらの進化にも期待したいです。